Flex Gateway新着情報

Governance新着情報

Monitoring API ManagerAnypoint Studio (Studio) エディターは、Mule アプリケーション、プロパティ、および設定ファイルの設計と更新に役立ちます。

Studio でコネクタを追加および設定する手順は、次のとおりです。

「アプリケーションログの表示」で説明されているように、コネクタを実行するときに、リアルタイムでアプリケーションログを表示して問題を確認できます。

Studio で初めてコネクタを設定する場合は、「Anypoint Studio を使用したコネクタの設定」を参照してください。このトピックを参照した後、コネクタ項目についての詳細情報が必要な場合は、「MuleSoft AI Chain Connector リファレンス」を参照してください。

Studio で、MuleSoft AI Chain 用 Anypoint Connector (MuleSoft AI Chain Connector) を追加および設定する新しい Mule プロジェクトを作成します。

Studio で、[File (ファイル)] > [New (新規)] > [Mule Project (Mule プロジェクト)] を選択します。

Mule プロジェクトの名前を入力して、[Finish (完了)] をクリックします。

MuleSoft AI Chain Connector を Mule プロジェクトに追加して、XML コードにコネクタの名前空間およびスキーマの場所を自動的に入力し、プロジェクトの pom.xml ファイルに必須の連動関係を追加します。

[Mule Palette (Mule パレット)] で、[(X) Search in Exchange ((X) Exchange 内を検索)] をクリックします。

[Add Dependencies to Project (連動関係をプロジェクトに追加)] で、検索項目に「mulesoft ai chain」と入力します。

[Available modules (使用可能なモジュール)] で [MuleSoft AI Chain Connector] をクリックします。

[Add (追加)] をクリックします。

[Finish (完了)] をクリックします。

Studio でコネクタを Mule プロジェクトに追加しても、Studio ワークスペースの他のプロジェクトはそのコネクタを使用できません。

ソースは、指定された条件が満たされたときにフローを開始します。 次のソースのいずれかを MuleSoft Chain AI Connector で使用するように設定できます。

[HTTP] > [Listener]

設定されたホストとポートで要求を受信するたびにフローを開始する

Scheduler

たとえば、[HTTP] > [Listener] ソースを設定する手順は、次のとおりです。

[Mule Palette (Mule パレット)] で、[HTTP] > [Listener] を選択します。

[Listener] を Studio キャンバスにドラッグします。

[Listener (リスナー)] 設定画面で、必要に応じて [Display Name (表示名)] 項目の値を変更します。

[Path (パス)] 項目の値を指定します。

[Connector configuration (コネクタ設定)] 項目の横にあるプラス記号 (+) をクリックして、アプリケーション内の [HTTP] > [Listener] ソースのすべてのインスタンスで使用できるグローバル要素を設定します。

[General (一般)] タブで、コネクタの接続情報を指定します。

[TLS] タブで、必要に応じてコネクタの TLS 情報を指定します。

[Advanced (詳細)] タブで、必要に応じて再接続戦略を含む再接続情報を指定します。

[Test Connection (接続をテスト)] をクリックして、Mule が指定されたサーバーに接続できることを確認します。

[OK] をクリックします。

フローにコネクタの操作を追加するときは、そのコネクタで実行するアクションを指定しています。

MuleSoft AI Chain Connector の操作を追加するには、次の手順に従います。

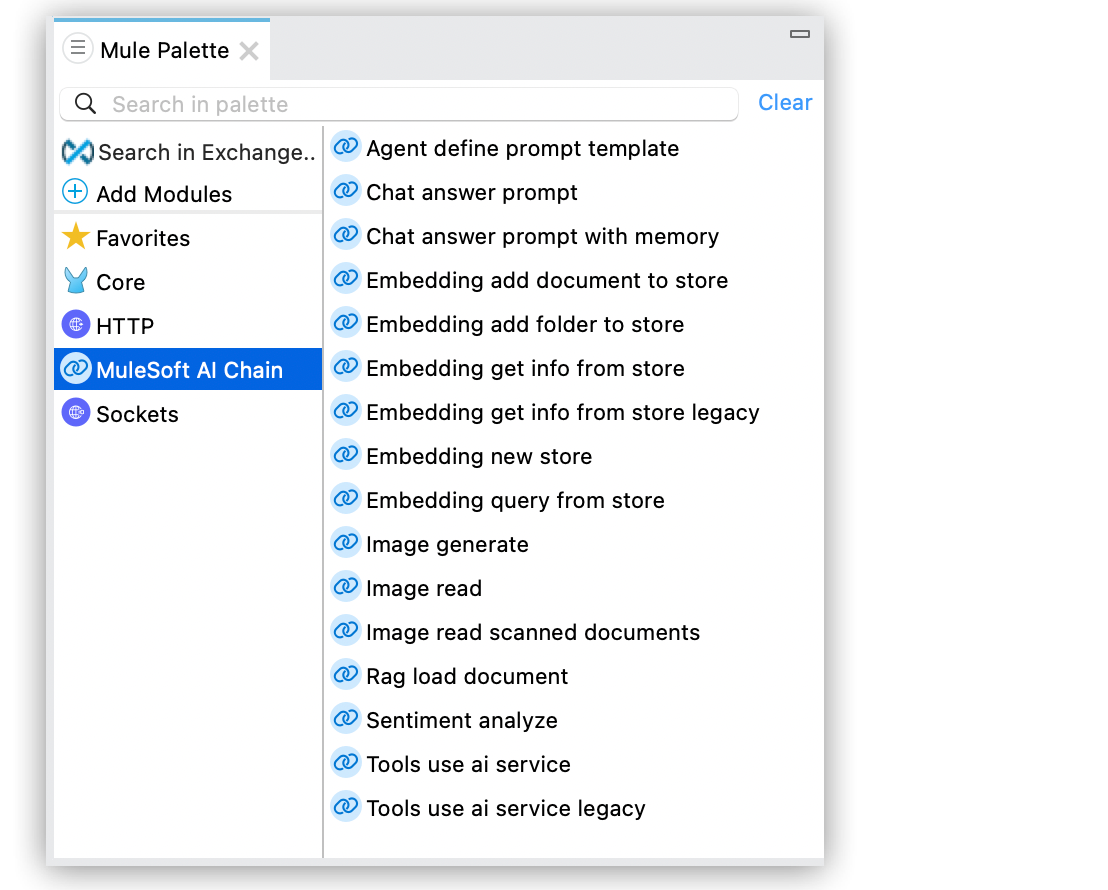

[Mule Palette (Mule パレット)] で [MuleSoft AI Chain Connector] を選択し、追加する操作を選択します。

が選択され、コネクタのすべての操作がリストされている Studio の [Mule Palette (Mule パレット)]"]

が選択され、コネクタのすべての操作がリストされている Studio の [Mule Palette (Mule パレット)]"]

その操作を Studio キャンバスのソースの横にドラッグします。

コネクタを設定する場合、アプリケーション内のそのコネクタのすべてのインスタンスで使用できるグローバル要素を設定します。グローバル要素を設定するには、コネクタが対象のシステムにアクセスするために必要な認証ログイン情報を指定する必要があります。

ANT スタイルのプロパティプレースホルダーを含む設定ファイルを参照するか (推奨)、グローバル設定プロパティに認証ログイン情報を入力できます。プロパティプレースホルダーを使用する利点とその設定方法については、「Anypoint Connector 設定」を参照してください。

MuleSoft AI Chain Connector のグローバル要素を設定する手順は、次のとおりです。

Studio キャンバスで操作を選択します。

操作のプロパティ画面で、[Add (追加)] (+) アイコンをクリックして、グローバル要素設定項目にアクセスします。

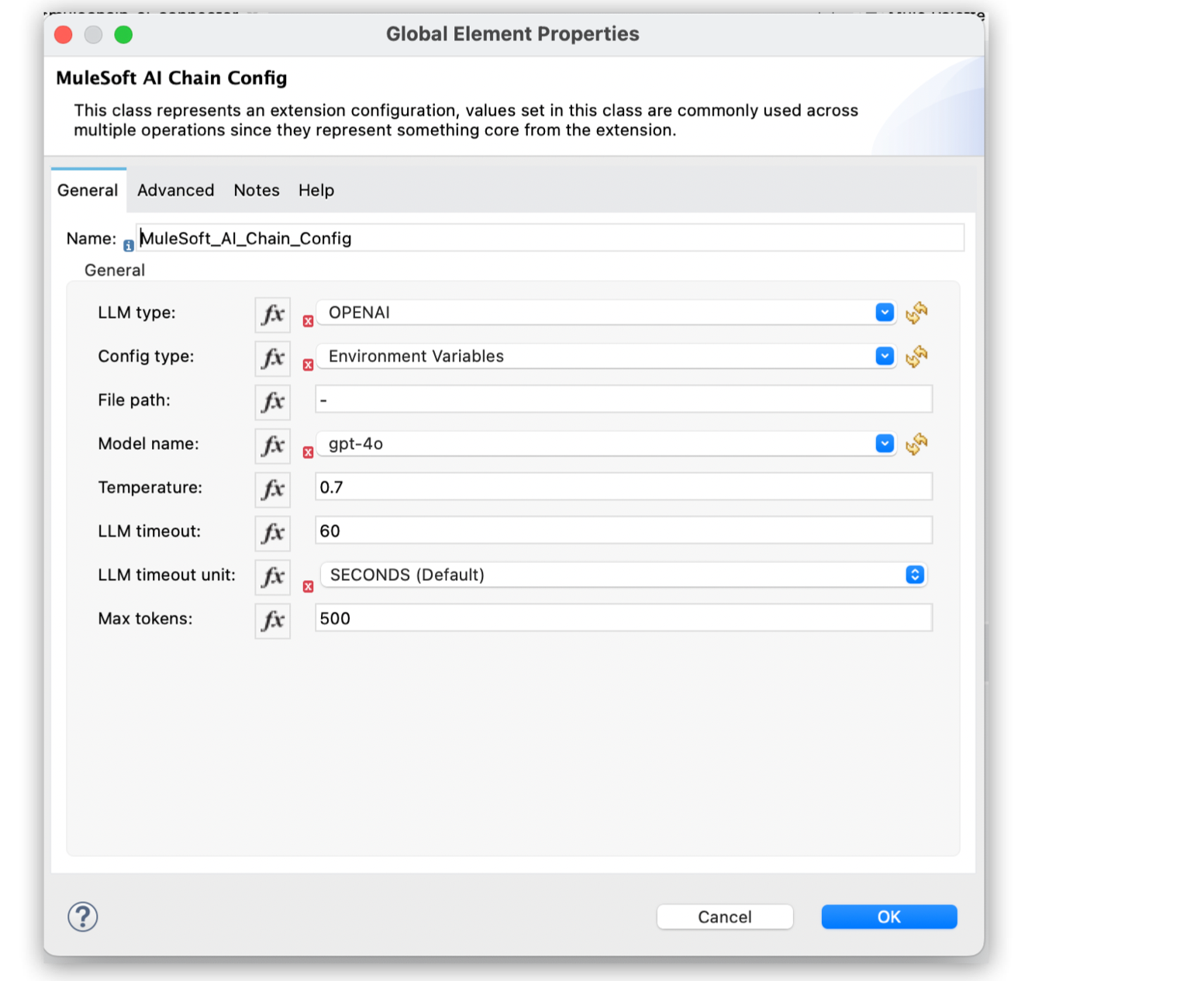

[Global Elements Properties (グローバル要素プロパティ)] > [General (一般)] タブで、目的の大規模言語モデル (LLM) 種別を [LLM] から選択します。

Anthropic

Azure OpenAI

Mistral AI

Ollama

OpenAI

GroqAI

[Config type (設定種別)] で、次の設定種別から選択します。

Environment Variables (環境変数)

この設定では、Mule Runtime がデプロイされているオペレーティングシステムで環境変数を設定する必要があります。このオプションを選択する場合、[File path (ファイルパス)] 項目に「-」と入力します。

選択した LLM 種別に基づいて、異なる環境変数を入力する必要があります。サポートされる LLM 種別に基づいてサポートされる環境変数を次に示します。

Anthropic: ANTHROPIC_API_KEY

AWS Bedrock: AWS_ACCESS_KEY_ID- AWS_SECRET_ACCESS_KEY

Azure OpenAI: AZURE_OPENAI_ENDPOINT- AZURE_OPENAI_KEY- AZURE_OPENAI_DEPLOYMENT_NAME

MistralAI: MISTRAL_AI_API_KEY

OpenAI: OPENAI_API_KEY

Ollama: OLLAMA_BASE_URL

Groq AI: GROQ_API_KEY

設定種別の各設定項目が入力されている [Global Element Properties (グローバル要素プロパティ)] ウィンドウ"]

設定種別の各設定項目が入力されている [Global Element Properties (グローバル要素プロパティ)] ウィンドウ"]

Configuration JSON (設定 JSON)

この設定では、すべての必要な LLM プロパティが含まれている設定 JSON ファイルを指定する必要があります。

設定 JSON ファイルの例を次に示します。

{

"OPENAI": {

"OPENAI_API_KEY": "YOUR_OPENAI_API_KEY"

},

"MISTRAL_AI": {

"MISTRAL_AI_API_KEY": "YOUR_MISTRAL_AI_API_KEY"

},

"OLLAMA": {

"OLLAMA_BASE_URL": "http://baseurl.ollama.com"

},

"GROQAI_OPENAI": {

"GROQ_API_KEY": "YOUR_GROQAI_APIKEY"

},

"ANTHROPIC": {

"ANTHROPIC_API_KEY": "YOUR_ANTHROPIC_API_KEY"

},

"AZURE_OPENAI": {

"AZURE_OPENAI_KEY": "YOUR_AZURE_OPENAI_KEY",

"AZURE_OPENAI_ENDPOINT": "http://endpoint.azure.com",

"AZURE_OPENAI_DEPLOYMENT_NAME": "YOUR_DEPLOYMENT_NAME"

}

}LLM 種別の必要なプロパティを入力したことを確認します。ファイルを外部に保存したり、次の DataWeave 式を使用してファイルを Mule アプリケーションの src/main/resource フォルダーの下に直接追加したりできます。

mule.home ++ "/apps/" ++ app.name ++ "/envVars.json"設定種別として [Environment Variables (環境変数)] を選択している場合、[File path (ファイルパス)] に「-」と入力します。[Configuration JSON (設定 JSON)] を選択している場合、JSON ファイルへのパスを入力します。または、ファイルを Mule アプリケーションの src/main/resource フォルダーの下に保存する場合は、DataWeave 式を入力します。

[Model name (モデル名)] では、LLM プロバイダーでサポートされるモデルから選択します。

[Temperature (温度)] には、0 ~ 2 の数値を入力するか、デフォルト値 0.7 を使用します。

温度は出力のランダム性を制御するために使用されます。設定する数値が高くなると、出力のランダム性が高くなります。設定する数値が低くなる (0 に向かう) と、値がより確定的になります。

[LLM Timeout (LLM タイムアウト)] には、要求をタイムアウトする時間 (秒数) を入力します。デフォルト値は 60 秒です。

[Max tokens (最大トークン数)] には、応答を生成するときに使用する LLM トークンの数を入力します。

このパラメーターは、LLM とやり取りするときの利用状況とコストを制御するのに役立ちます。

[OK] をクリックします。

問題を確認するため、アプリケーションログを次の方法で表示できます。

アプリケーションを Anypoint Platform から実行している場合、アプリケーションログ出力は Anypoint Studio のコンソールウィンドウに表示されます。

コマンドラインから Mule を使用してアプリケーションを実行している場合、アプリケーションログ出力はオペレーティングシステムコンソールに表示されます。

アプリケーションのログファイル (log4j2.xml) でログファイルパスがカスタマイズされていない場合、デフォルトの場所 MULE_HOME/logs/<app-name>.log でアプリケーションログを表示することもできます。ログパスは、アプリケーションログファイル log4j2.xml で設定できます。